* Multipath란?

리눅스 시스템에서는 스토리지 시스템 (FC, SAS, iSCSI 등)연결시 동일한 디스크를 하나의 통로가 아닌 여러개의 경로로 액세스하게 할 수 있다. Multipath는 이러이러한 중복 경로를 가지는 가상 스토리지 장치를 구성할 수 있도록 하여 시스템에서 스토리지 접근 시 여러 경로를 사용하도록 한다. 이러한 중복 경로는 다음과 같은 이점을 가진다.

- 가용성 증가 : 여러개의 경로 중 하나의 경로에 문제가 생겨도, 시스템은 남은 정상적인 경로로 스위치하여 운영에 문제가 없게 한다. 다만 스토리지 자체가 문제가 생기면 사용은 불가하게 된다.

- 대역폭 증가 : 여러개의 경로를 그룹으로 모아 스토리지 대역폭을 넓혀 성능을 향상시킬 수 있다.

아래는 HBA 카드를 통해 FC를 사용하여 스토리지에 접근하는 예시이다. 서버가 아래처럼 2개의 FC HBA를 가지고 있다. 각 연결은 독립된 FC 스위치에 연결되며, 또한 스토리지 ARRAY에 있는 독립된 컨트롤러와 연결되게 된다.

다른 예시로, 이전 iSCSI 에서 Portal 주소가 1개가 아니라 여러개인 경우, 하나의 target IQN이지만 Portal 주소 경로가 여러개이므로 이 Muiltipath를 구성하여 가용성을 높이거나 대역폭을 증가시킬 수 있는 것이다.

* Multipath 설치 패키지

레드햇 엔터프라이즈 리눅스는 device-mapper-multipath 라는 패키지를 통해 Multipath의 기본적인 바이너리와 데몬을 제공한다. 이 데몬을 통해 시스템은 동일한 디스크와 연결된 여러개의 경로를 자동으로 감지하고, /etc/multipath.conf 파일의 설정에 따라 그룹으로 결합한다. 그룹은 여러 경로로 구성될 수 있다. 이 구성을 사용하면 시스템이 그룹 내부의 경로 사이에 I/O 트래픽을 분산한다.

또한 레드햇 엔터프라이즈 리눅스는 dm-multipath 서브시스템을 사용하여 multipath 지원을 제공한다. dm_multipath 커널 모듈은 가상 디바이스를 생성한다. (여러개의 경로를 가진 하나의 가상 디스크) multipathd 데몬은 이러한 가상 디바이스를 관리하고, 각 경로를 모니터링한다. 사용자는 multipath 명령어를 통해 멀티패스 장치의 상태를 확인할 수 있다.

멀티패스 패키지를 설치할때는 아래와 같은 명령어를 수행한다.

* Multipath 이름 및 구성

커널은 모든 멀티패스 장치 (가상디바이스)에 WWID(World Wide Identifier)를 할당한다. WWID는 글로벌하게 유니크하며, 바뀌지 않는다. 디폴트로, 시스템은 멀티패스 장치명을 WWID로 세팅한다. 시스템은 또한 /dev/mapper 디렉토리에 각각의 WWID로 된 장치 파일을 생성한다. 그러나 이 WWID 는 길고 복잡하여 식별이 어렵다.

/etc/multipath.conf 파일에서 만약 user_friendly_names 옵션을 yes로 세팅하는 경우, 시스템은 심플하고 변하지 않고 유니크한 값을 해당 멀티패스 장치에 할당한다. 이 이름의 형태는 /dev/mapper/mpathN 로 만들어진다. 또한 만약 해당 멀티패스 장치가 파티션을 가졌다면, 시스템은 또한 파티션에 대한 디바이스 명을 만든다. 예를들어, /dev/mapper/mpathap1은 /dev/mapper/mpatha 장치의 파티션1이다.

또한 mpath라는 기본 이름 말고 사용자가 직접 커스텀해서 사용할 수 있다. /etc/multipath.conf에서 multipaths 섹션에 alias 옵션을 사용하면 된다.

시스템은 WWID가 장치 이름에 매핑된 정보를 /etc/multipath/bindings 파일에 저장한다. 모든 동일한 클러스터 노드에서 동일한 이름을 가지려면, 각 노드에 /etc/multipath/bindings를 똑같이 배포해야 한다.

시스템은 /dev 경로에 디스크 장치에 대하여 /dev/dm-N 의 형태로 이름을 생성한다. 이러한 장치는 엄격하게 시스템 내부용으로만 사용된다. 저장소에 액세스하는 데 직접 사용하지 말 것.

* Multipath 구성파일

위와 같이 multipath 패키지를 설치한 후에는 /etc/multipath.conf 파일을 생성하여 multipath 구성을 사용자가 직접 config 해야한다. 이 파일은 자동으로 생성되지 않으며, 또한 이 파일이 없으면 multipathd 데몬 서비스는 시작하지 않는다. 이 multipath.conf 파일을 생성하기 위해서는 다음 명령을 사용한다.

이 명령은 /etc/multipath.conf 파일을 생성하고, multipathd 데몬도 시작한다. 또한 mpathconf 명령은 가장 자주 사용되는 구성 파라미터를 세팅할 수 있는 추가적인 옵션을 허용한다. 예를들어 해당 명령은 default로 user_friendly_names 을 y로 활성화하는데, --user_friendly_names n 옵션은 이 파라미터를 multipath.conf 구성파일에서 사용하지 않도록 한다.

user_friendly_names 설정을 y로 하면, /dev/mapper/mpathX 라는 이름으로 multipath 장치가 생성되며, n으로 설정하면 멀티패스 디바이스에 WWID를 기반으로 한 이름이 지정된다.

또한 multipath.conf 파일을 수정하는 경우, multipathd 데몬을 재시작해야 한다.

multipath.conf 파일을 구성이 어려운 경우, 쉽게 구성하도록 하기 위해 레드햇에서는 멀티패스 헬퍼라는 툴을 제공한다. 아래 사이트에서 해당 헬퍼를 사용해볼 수 있다. https://access.redhat.com/labs/multipathhelper

* multipath.conf 파일 톺아보기

/etc/multipath.conf 파일은 아래 섹션으로 구성되어있다.

blacklist{}

- 디스크의 경로들을 찾는동안, 시스템은 찾을 수 있는 모든 장치를 multipath topology에 추가한다.

- 블랙리스트 섹션을 설정하면 이러한 토폴로지 추가에서 제외할 장치들의 리스트를 정의한다.

blacklist_exceptions{}

- 블랙리스트 섹션에 나열되어있음에도 불구하고, 멀티패스 토폴로지에 포함해야 하는 장치를 정의한다.

defaults{}

- 이 섹션은 devices나 multipaths 섹션에 명확하게 덮어씌워지지 않는 이상 모든 멀티패스 장치들에 대하여 디폴트 세팅을 정의한다.

- 즉 여기 설정은 devices나 multipaths 설정보다 후순위라는 것.

devices{}

- device 섹션에는, 특정 타입의 storage controller에 대한 default 섹션에서 정의한 것의 재정의 (덮어씌우는)가 포함된다.

- 시스템은 vender, 제품, revision 키워드를 통해 device를 식별한다.

- 이러한 키워드는 sysfs에 있는 정보와 일치되는 정규표현식이다.

multipaths{}

- 특정 multipath devices에 대한 설정이 포함된다.

- 이 설정은 defaults와 devices에서 정의한 파라미터를 덮어씌운다.

- 시스템은 멀티패스 장치의 WWID 로부터 멀티패스 장치를 식별한다.

특정 multipath device의 파라미터를 검색하려면, 시스템은 multipaths 섹션에서 먼저 일치하는 device를 찾고, 그다음 devices 섹션에서 찾는다. 위 두 섹션에서 일치하는 항목을 찾지 못하는 경우, 이제 파라미터를 defaults에서 찾는다. 즉 multipaths > devices > defaults 순으로 찾는다는 것이다.

* defaults() 파라미터 상세

multipath -t 명령을 사용하여 현재 구성 정보를 볼 수 있다. 여기에는 구성 파일에 명시적으로 세팅되지 않은 모든 파라미터를 보여준다. multipath.conf(5) man 페이지에서 각 파라미터의 기본값을 볼 수 있다. 아래는 몇가지 useful한 세팅들을 보여준다.

path_selector

- 이 설정은 I/O에 사용될 "그룹안에 있는 경로"를 선택하는데 있어 멀티패스가 사용할 알고리즘을 세팅한다.

- service-time 0 : 기본값이다. 예상 서비스 시간이 가장 짧은 경로로 다음 I/O 요청을 보낸다.

- round-robin 0 : 그룹 안의 모든 경로에 걸쳐 I/O를 분배한다.

- queue-length 0 : 처리되지 않은 요청 (outstanding request)의 대기열이 가장 짧은 경로로 다음 I/O 요청을 보낸다. (The "queue-length 0" algorithm sends the next I/O request to the path with the shortest queue of outstanding requests. )

path_grouping_policy

- 이 설정은 시스템이 path(경로)를 그룹으로 결합하는 방법을 정의한다.

- 기본 값은 failover 로, multipath가 각 경로를 별도의 그룹에 넣도록 지시한다. 이 구성을 쓰면 시스템은 I/O에 한나의 경로만 사용하고 장애 발생 시 다음 경로로 전환한다.

- multibus 정책을 사용하면, 시스템은 모든 가능한 경로를 하나의 그룹으로 합친다. 그다음 multipath는 path_selector 알고리즘 설정에 따라서 I/O 요청을 경로들에게 분배한다.

- multibus로 매개변수를 설정하기 전에, storage controller가 active-active 연결을 지원하는지 확인해야 한다.

path_checker

- 이 설정값은 multipathd 데몬이 path가 정상인지 확인하는 방법을 구성한다.

- 기본값은 tur 이며, 이 값은 multipathd 데몬이 TUR(Test Unit Ready) SCSI 명령을 사용하여 스토리지 컨트롤러의 상태를 검색하도록 지시한다.

- 일부 path 검사기는 특정 하드웨어에서만 작동한다. 예를들어 emc_clariion 검사기는 EMC VNX 스토리지를 위해 사용되고, hp_sw 검사기는 HPE MSA 스토리지를 위해 사용된다.

- PATH 검사기는 종종 스토리지 장치에 따라 달라질 수 있으므로, 사용자는 일반적으로 path_check 파라미터를 구성파일의 devices 섹션에다 세팅한다.

no_path_retry

- 이 설정은 모든 path가 fail되었을때 multipath 동작을 제어한다. 디폴트값은 fail 이며, multipath가 즉시 상위 레이어에 I/O 에러를 보고한다.

- 이 파라미터는 또한 오류를 보고하기 전에 재시도 회수를 나타내는 값으로 숫자를 사용할 수 있음.

- 값을 queue로 하면, multipath 경로가 정상화될 때까지 모든 I/O 요청들을 대기열에 추가한다. 이 조건에서는, 일부 프로세스가 중단되지 않는 sleep 상태로 영원히 hang 걸릴 수 있음.

user_friendly_names

- multipath device가 이름을 WWID로 받거나 (no 설정) mpathN으로 받게 (yes 설정) 할 수 있다.

* multipath가 아닌 장치를 제외하기

관리하는 디스크들 중에 multipath가 되지 않도록 할 제외 리스트를 사용한다. 일반적으로 로컬 디스크나 이중화 경로가 없는 스토리지 컨트롤러들에서 설정한다. 이러한 장치들은 /etc/multipath.conf 구성파일의 blacklist 섹션에서 정의한다.

find_multipaths 라는 파라미터가 있다. 이 파라미터는 defaults 섹션에서 정의되는데, yes로 하는경우 이 파라미터는 자동으로 하나의 패스만 있는 모든 장치를 멀티패스에서 제외한다. 이 구성은 로컬 디스크나 이중화 경로가 없는 storage device가 멀티패스 되는것을 막는다. 이렇게 쓰면, 보통으로 blacklist 섹션에는 아무것도입력하지 않는다.

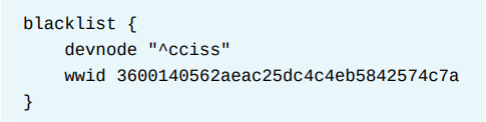

직접 구성파일에서 제외하는 경우, 아래처럼 blacklist에 디스크를 명시하거나 (wwid 등으로) devnode 매개 변수를 사용하여 장치 파일을 기반으로 장치를 제외할 수 있다. 두 방법 모두 정규식을 사용할 수 있다. 아래 예시는 두가지 방식 모두를 보여준다.

또 다른 방식은 blacklist 섹션을 사용하여 모든 디바이스를 제외시킨 다음 blacklist_exceptions 섹션을 사용하여 개별 디바이스를 허용하는 방법도 있다. 이 구성에서 blacklist_exceptions 섹션은 an inclusive list으로 작동하게 된다.

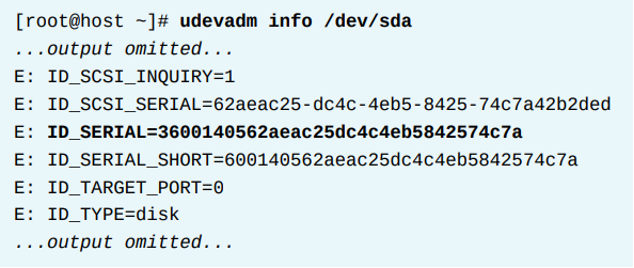

* wwid 찾기

시스템은 device의 serial number를 WWID에 사용한다. 시스템은 udev 데이터베이스를 쿼리하여 해당 정보를 가져온다. udev 데이터베이스는 시스템의 모든 device 목록과 속성을 유지관리한다. 따라서 udevadm info 명령을 사용하여 해당 데이터베이스를 볼 수 있다. 예를들어 iSCSI를 통해 등록된 디스크가 /dev/sda인 경우, 아래 명령으로 wwid를 찾을 수 있다.

이 예시는 장치 파일 (/dev/sda)가 ID_SERIAL이라는 속성으로부터 WWID를 검색하여 인수로서 쓰는것을 보여준다. 이 36으로 시작하는 문자열을 multipath.conf의 wwid로 사용하면 된다.

* Multipath를 제공하는 스토리지 종류별 멀티패스 설정 구성하기

스토리지 종류에 따라 Multipath 설정을 다르게 해야할 수 있다. 대부분 일반적인 스토리지 하드웨어는 이미, built-in defaults에 정의된 스토리지들의 섹션이 있다. multipath -t 명령을 통해, 이러한 스토리지 컨트롤러의 구성정보를 볼 수 있다. 아래 예시는 알려진 장치의 몇몇 리스트이다.

만약 해당 리스트에 현재 사용자가 쓰고 있는 스토리지가 리스트에 없다면, 설정값을 찾아 섹션을 추가해야 한다. 현재 Multipath로 사용할 디스크의 스토리지 정보는 여러가지 명령들로 확인 가능하다.

- multipathd show paths format "%d %s" (vendor, product, revision 등)

- cat /sys/block/sda/device/vendor

- cat /sys/block/sda/device/model

- cat /sys/block/sda/device/rev

아래는 존재하지 않는 스토리지 하드웨어에 대한 정보를 정의한 예시이다. 위 명령어들로 확인된 값들을 넣을 수 있다.

* 특정 경로의 상세 정보를 구성하기

specific multipath devices의 경우, 사용자는 multipaths{ } 섹션을 사용하여 defaults{ }와 devices{ } 섹션의 파라미터 값들을 덮어씌울 수 있다.

multipaths 섹션의 일반적인 용도 중 하나는 mulitpath device의 alias를 정의하는 것이다. alias를 정의하면, 시스템은 /dev/mapper/ 디렉토리 안에 있는 device 파일의 이름을 해당 alias로 사용한다. 따라서 여러 multipath devices 들을 더 쉽게 구분할 수 있다. 예를들어, 아래 구성은 해당 multipath device인 WWID 3600140562~~를 알리아스를 clusterstorage라고 설정했다. 결과적으로multipath는 /dev/mapper/clusterstorage라는 디바이스 파일을 생성하게 된다.

* Multipath 장치에 대한 파티션을 만들기

multipath device에서 파티션 생성하려면, 아래 두가지 방식 중 한가지를 선택해서 수행한다.

- 파티션 에디터를 사용한다. parted /dev/mapper/mpatha (상세한 parted의 설명은 여기서는 제공하지 않음)

- udevadm settle 명령 사용. 이 명령은 시스템이 새 파티션을 감지하고 /dev/mapper/ 디렉터리에 관련 장치 파일을 생성할 때까지 기다린다. 완료된 경우에만 결과를 리턴한다.

* Multipath 장치 삭제하기

multipath device의 모든 경로를 제거한 후에는, multipath -f <multipath_device> 명령으로 멀티패스 장치를 클리어한다. 만약multipathd 데몬이 실행중이 아니고, 여전이 multipath device 파일이 존재한다면, 그때는 multipath -F 명령으로 모든 멀티패스 장치들을 flush 한다. (완전히 제거하는 명령)이 명령은 다양한 구성을 테스트할 때 이전 구성의 남아있는것들을 제거하려는 경우에 유용하다.

* Multipath 장치 상태 확인하기

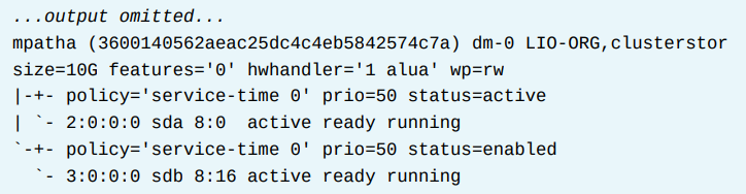

multipath -ll 명령은 모든 경로를 컨트롤하고 그들의 스테이터스를 보여준다. 각 multipath device의 정보를 보여준다. 각 device에 대하여, 이 명령은 path group과 각 그룹에 있는 path들을 보여준다. 가장 많이 사용한다. 또한 multipath -l 명령은 multipath topology에 대한 quick review를 보여준다.

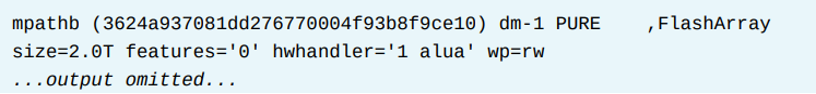

아래 예시에서는 두개의 multipath device가 있다. (mpathb, mpatha)

기본 정보

- 첫번째 라인은 user-friendly name (mpathb)를 보여주고, 그다음 device의 WWID를 보여준다. 그리고 vendor와 product 이름을 보여준다.

- 두번째 라인은 devices size, 그리고 write permission (wp) 및 다른 상세사항을 보여준다.

각 path 그룹

- 위는 아래는 각 path 그룹을 보여준다. 이 예시에서는, mpathb 는 2개의 path group을 가진다. 한 번에, 하나의 path group만 active 되어있다.

- 그리고 multipath는 active group이 fail되는 경우 inactive group으로 스위치한다.

- 여기서 status 부분이 path group이 active 되어있는지를 보여준다. 두번째 path group은 enabled로 되어있는데, 이것은 active 그룹이 fail에 대비해 이 path group이 ready 상태라는 것을 의미한다.

- policy 부분은 group의 path들 사이에 I/O 요청을 어떻게 분배할지 multipath가 사용하는 알고리즘을 명시한다. 이 속성은path_selector 파라미터와 연관되어있다.

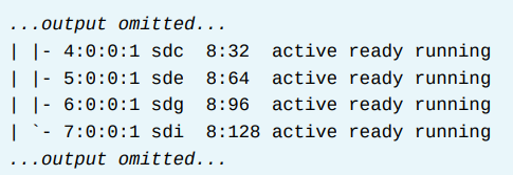

path 그룹 아래에 path 리스트

- 각 path group,은 위와 같이 path들의 리스트가 있다. multipath는 active group안에 있는 모든 path 들 사이에 I/O 요청을 분배한다.

- 이 status 정보는 path의 상태를 가늠하는데 도움을 준다. up 되어있고 I/O 작업에 대해 준비가된 PATH는 ready 상태이다.

- 다운된 path는 faulty로 나온다.

- 위 이미지의 failed, faulty 각각은 동일한 정보를 보여준다. failed는 커널의 관점에서 path device 의 상태를 리포트한다. faulty는multipath path 검사기로부터 나온 상태를 보여준다.

- /etc/multipath.conf 파일은 path_checker 파라미터를 사용함으로써 path 검사기를 정의한다.

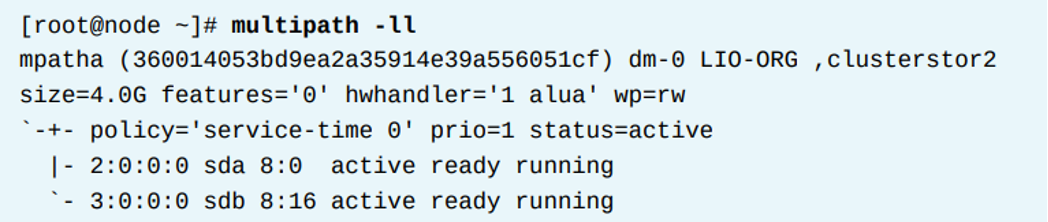

다른 예시

- 아래 결과는 시스템이 두번째 multipath device를 가진 것을 보여준다. 이 devie의 이름은 mpatha이다.

- 이 devie는 2개의 포트그룹을 가졌고 각 그룹마다 하나의 path를 가지고 있다.

* path group 정책 식별하기

multipath -ll 명령은 multipath device의 path 그룹화 정책을 명시적으로 보여주지 않는다. 그러나, 명령의 결과를 잘 보면 해당 정보를 추론할 수 있다.

- path 그룹화 정책이 failover인 multipath device 는 각 그룹마다 오직 하나의 path만 가진다.

- 아래 결과는 이 정책의 예시를 보여준다. 각 path 그룹은 단일 path를 포함한다.

- path 그룹화 정책이 multibus인 multipath device 는 모든 path를 하나의 그룹에 넣는다.

- 아래 예시는 하나의 path group을 보여준다. 모든 path는 하나의 group의 멤버가 된다.

* Failover 확인하기

multipath -ll 명령어는 multipath device의 failover 활동을 가늠하는데 도움을 준다. 주어진 시간에 단 하나의 path group만 active 상태에 있어야 한다. 남아있는 path group들은 enabled 상태로서 wait 하고 있다. 아래 정상 상태의 예시를 보자.

아래 예시는 passive path group의 한 path가 fail되었을 때 multipath -ll 명령의 결과 내부의 변화를 보여준다. passive path group에 있는 path의 상태가 변경되었다 하더라도, active path group과 여기에 연계된 path의 상태는 변경되지 않고 손상되지 않은 상태로 유지된다.

아래 예시는 active path group이 fail된 것을 보여준다. 이전에 active path (2:0:0:0) 가 failed faulty offline 상태이다. 이에 따라, 이것과 연관된 path group의 상태도 또한 변경된다. active에서 enabled로 변경되는 것이다. passive path group은 active가 된다.

위와 같이 문제가 발생한 후, failed path가 회복된다 하더라도, 현재 active path는 active 인 그대로 남는다. 만약 사용자가 이러한 동작을 컨트롤하고 싶으면 /etc/multipath.conf 파일의 failback이라는 파라미터를 수정하면 된다. 이 failback 파라미터의 default 값은manual이다. manual이면 이전 원래 패스로 돌아가지 않고 그대로 유지하는 것이다.

* References

mpathconf(8), multipath.conf(5), and udevadm(8), multipath(8) man pages

For more information, refer to the Overview of Device Mapper Multipathing and Multipath devices chapter in the Configuring device mapper multipath guide at

The Red Hat Multipath Helper Tool

https://access.redhat.com/labs/multipathhelper/

For more information, refer to the The multipath command section in the Configuring device mapper multipath guide at

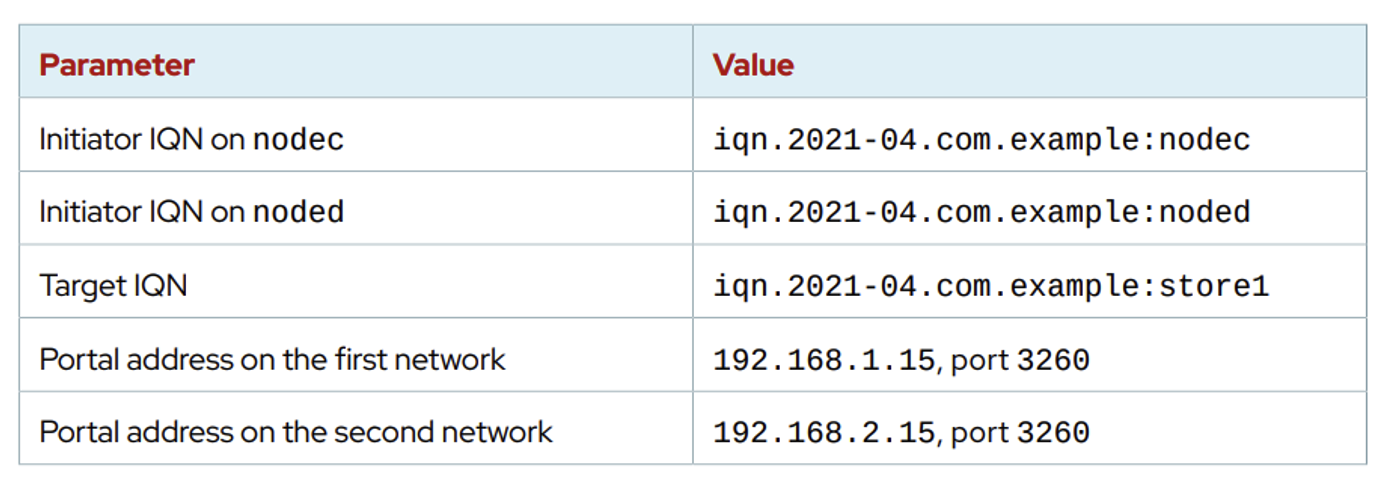

* lab : multipath를 사용하여 스토리지에 이중화 구성하기

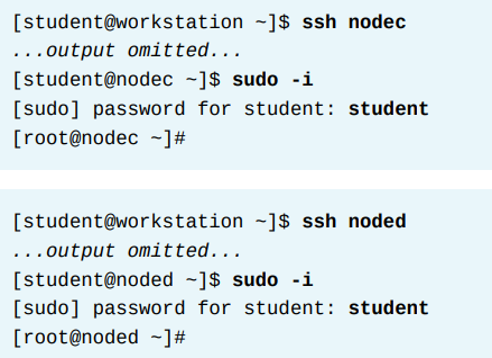

nodec, noded에서 작업을 수행한다.

1. 두 노드 로그

2. 이니시에이터 설치

3. 각 노드에 /etc/iscsi/initiatorname.iscsi를 설정한다. 각각 nodec와 noded에 맞춰서 적용한다.

4. iscsi 재시작

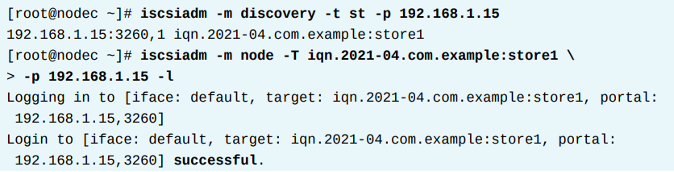

5. nodec, noded 각각 discover 진행 (192.168.1.15)

만약 실패하는경우, 각 노드에서 /etc/iscsi/initiatorname.iscsi 파일에 내용을 잘 넣었는지 확인

6. nodec, noded 각각 다시한번 discover 진행 (192.168.2.15)

여기까지 하면 디스크가 보일것이다.

7. 멀티패스 설치

8. nodec에서 conf 파일을 만든다. 설정완료후 noded로 복사할것이다.

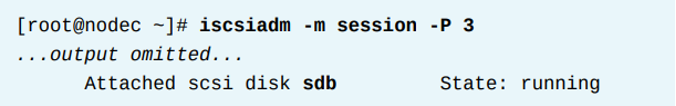

9. nodec에서, 새로 생긴 disk를 확인한다. 그리고 해당 iscsi storage의 wwid도 확인한다.

10. 멀티패스 파일을 수정한다. 알리아스를 disk1로 만든다.

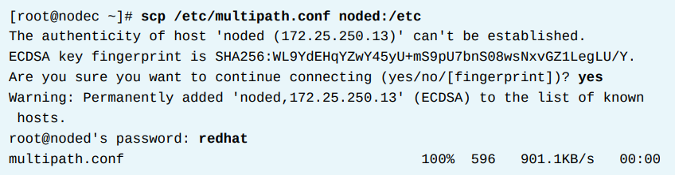

11. 멀티패스 파일을 복사한다.

12. 두 노드 모두 멀티패스 데몬 실행하고 enable 한다.

13. 둘다 멀티패스 결과 확인이 가능하다.

14. 각 장치에 알리아스가 잘 들어갔는지도 확인한다.

15. 해당 멀티패스 디스크를 가지고 파일시스템을 만든다. 주의할 점은, 만든 파일시스템을 각각 한 번에 하나의 노드에만 마운트해야한다.

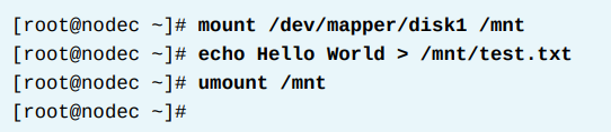

우선 nodec에서 파일시스템을 만든다.

그리고 nodec에서 마운트를해보고 파일을 i/o를 발생시킨다 그리고 마운트를 해제한다.

noded에서 마운트를 해서 값을 확인한다. 그리고 마운트를 해제한다.

* lab : multipath로 이중화 된 스토리지 failover 테스트

노드a에서 /dev/mapper/mpatha가 이미 연결되어 있다. 파일시스템을 만들자. 그리고 마운트까지 하자.

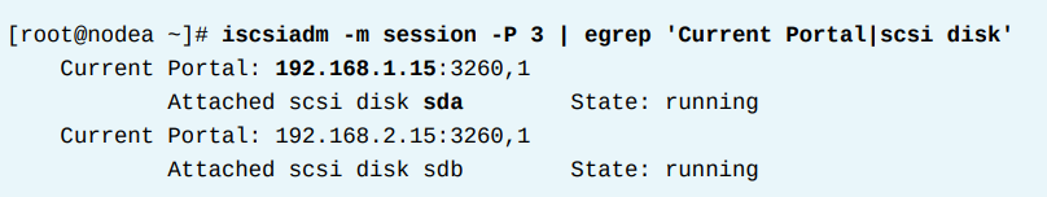

이제 path의 상태를 본다.

현재 active path는 sda이다.

이제 active path의 연결을 제공하는 iscsi 네트워크 정보를 확인한다. iscsiadm 명령으로 active path가 사용하고 있는 ip주소와 remote portal을 확인할 수 있다.

여기 보면 /dev/sda 는 192.168.1.15 target에 access 하고있다.

ip route 명령을 써서, 시스템이 remote portal에 접근하는데 사용하는 네트워크 장치의 이름을 찾는다.

eth2를 쓴다.

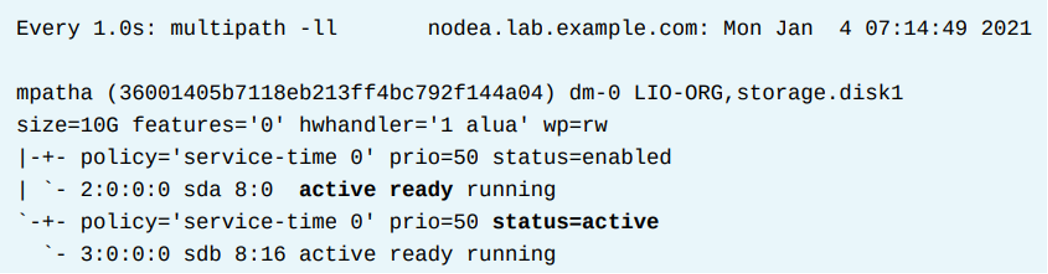

이제 failover를 보고 파일시스템 접근도 되는지 확인할 것이다. 우선 watch 명령으로 상태를모니터링한다.

새로운 터미널을 열어 nodea에 로그인하고, 루트유저로 들어간다음, eth2 네트워크를 끊는다.

위의 watch 명령으로 보던게 상태가 바뀐걸 알 수 있다.

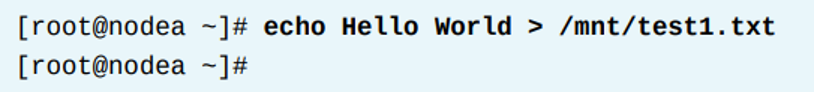

또한 마운트된곳에 i/o를 일으켰을때 잘 되는지 보자.

이제 다시 정상화시킨다.

그러면, iscsi 스토리지의 이중화는 회북되는것을 볼 수 있다.

하지만 현재 active는 아까 바뀐 그대로 아래가 active인것을 알 수 있으며, failback은 하지 않는다.

다시 i/o를 일으켜서 문제없는지 보자.

'High Availability > RH436 & EX436' 카테고리의 다른 글

| [RH436/EX436] 9. High Availability 클러스터의 2가지 LVM 구성 방식 (0) | 2024.02.07 |

|---|---|

| [RH436/EX436] 8. LVM Basic (1) | 2024.02.07 |

| [RH436/EX436] 6. iSCSI 연결 (1) | 2024.02.06 |

| [RH436/EX436] 5. 클러스터 관리 (0) | 2024.02.06 |

| [RH436/EX436] 4. 리소스 - 리소스 관리와 Constraint (0) | 2024.02.03 |