| 가상머신 전체 리스트 확인 | virsh list --all | [root@workstation ~]# virsh list --all Id Name State ----------------------------------- - rhel8.3-node1 shut off - rhel8.3-node2 shut off - rhel8.3-node3 shut off - rhel8.3-node4 shut off - rhel8.3-storage shut off - rhel8.3-template shut off |

| 가상머신 시작 | virsh start [가상머신명] | [root@workstation ~]# virsh start rhel8.3-node1 Domain rhel8.3-node1 started |

| 가상머신의 스냅샷 확인 | virsh snapshot-list [가상머신명] | [root@workstation ~]# virsh snapshot-list --domain rhel8.3-node1 Name Creation Time State -------------------------------------------------- snapshot1 2023-12-12 16:47:09 +0900 shutoff |

| 가상머신 스냅샷 복구 | virsh snapshot-revert [노드명] [스냅샷명] | [root@workstation ~]# virsh snapshot-revert rhel8.3-storage snapshot3 |

| 가상머신 스냅샷 만들기 | virsh snapshot-create-as --domain [노드명] [스냅샷명] | [root@workstation ~]# virsh snapshot-create-as --domain rhel8.3-storage snapshot3 Domain snapshot snapshot3 created |

| 가상머신 스냅샷 삭제 | virsh snapshot-delete --domain [노드명] [스냅샷명] | [root@workstation ~]# virsh snapshot-delete --domain rhel8.3-node1 snapshot1 Domain snapshot snapshot1 deleted |

| 가상머신 스냅샷 상세정보 보기 | virsh snapshot-dumpxml --domain [노드명] --snapshotname [스냅샷명] | virsh snapshot-dumpxml --domain rhel8.3-node1 --snapshotname snapshot1 <domainsnapshot> <name>snapshot1</name> <description>1.hostname 2.yum config 3.iso file copy 4.network setting 5./etc/hosts setting (4,5 settijng is related with node1,2,3,4 and storage)</description> <state>shutoff</state> <creationTime>1702367229</creationTime> <memory snapshot='no'/> <disks> <disk name='vda' snapshot='internal'/> ...중략... |

| 가상머신 xml 정보 보기 | virsh dumpxml [노드명] | [root@workstation ~]# virsh dumpxml rhel8.3-node1 setlocale: No such file or directory <domain type='kvm' id='2'> <name>rhel8.3-node1</name> <uuid>81a85d57-85f9-4326-9a97-5db96e043033</uuid> <metadata> </libosinfo:libosinfo> </metadata> <memory unit='KiB'>4194304</memory> <currentMemory unit='KiB'>4194304</currentMemory> ...중략... |

| 가상머신 xml 정보 수정하기 | virsh edit [노드명] |

'High Availability > Lab Environment' 카테고리의 다른 글

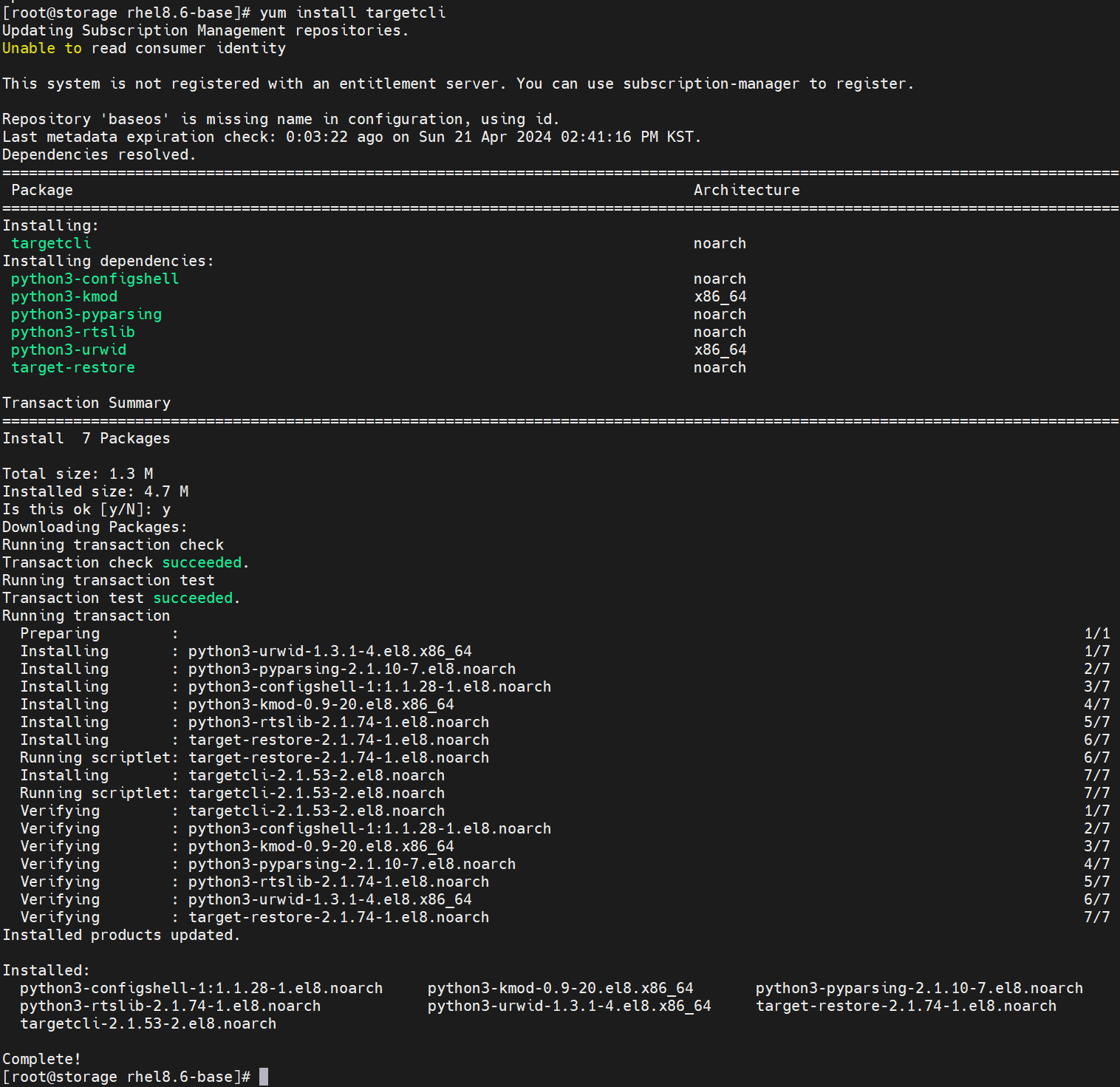

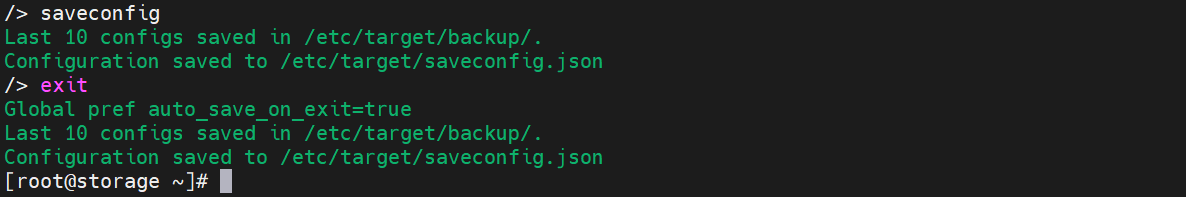

| iSCSI (targetcli) 구성 (0) | 2024.04.21 |

|---|---|

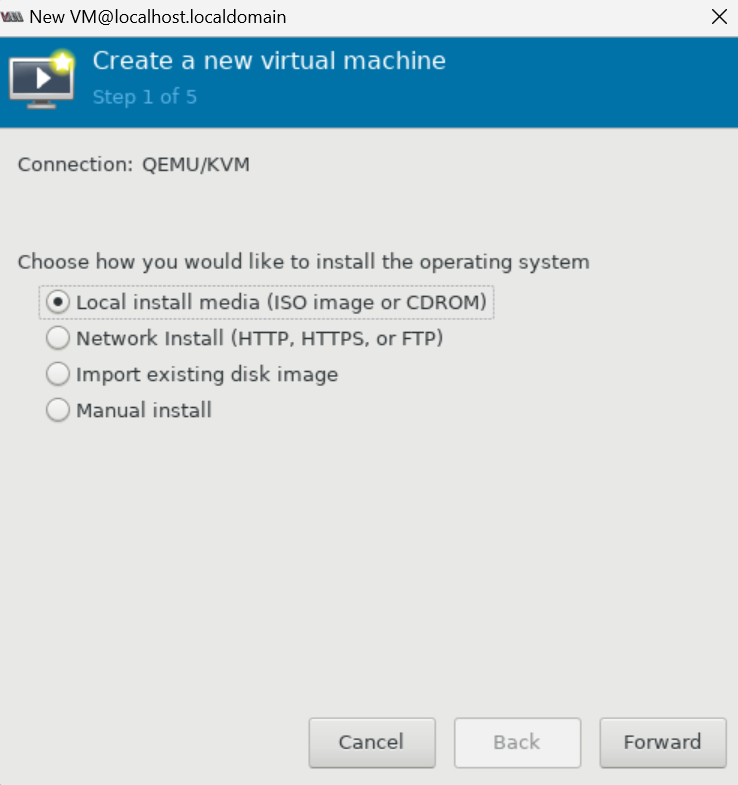

| [QEMU-KVM] RHEL8에서 KVM 가상머신 생성 (0) | 2024.04.19 |

| [QEMU-KVM] RHEL8에서 KVM 가상머신 환경 및 네트워크 구성 (HA 클러스터용) (0) | 2024.04.19 |

| [QEMU-KVM] High Availability 실습 가상머신 구성 (0) | 2024.02.17 |

| Fence_xvm 구성하기 (0) | 2024.02.15 |